高性能人工智能(AI)数据中心正在以前所未有的方式重塑半导体设计版图和投资方向。早在2022年,AI基础设施方面的支出规模就已接近150亿美元。而今年这一数字可能轻松突破600亿美元大关。没错,“吸金”,各种资金正从各种投资计划中向数据中心涌入。

显然,我们正处在一个人工智能资本支出空前高涨的时代——尽管DeepSeek等新入局者的潜在影响尚难以被准确估量。但不可否认的是,就在英伟达(Nvidia)、AMD等公司的高性能计算(HPC)处理器成为行业焦点的同时,用于存储训练和推理模型的高带宽内存同样迎来了属于自己的时代。据推测,2024年DRAM营收预计将创下近1160亿美元的新高。

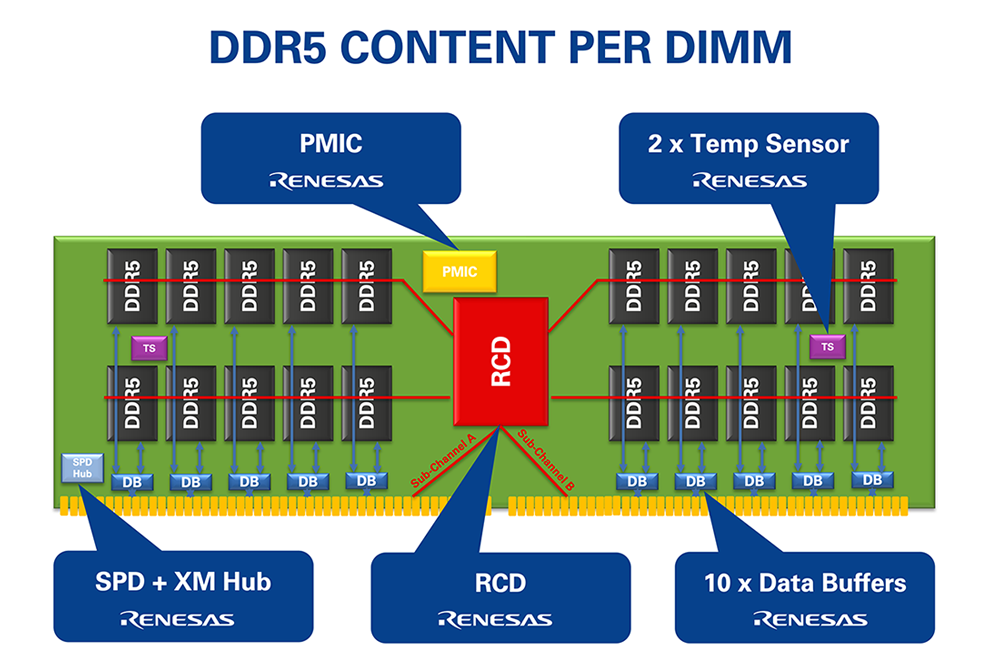

随着数据中心服务器的不断升级,CPU内核数量持续增加,这就需要更大的内存容量来为每个处理器内核提供更高带宽的数据支持。然而,物理定律的限制突显,CPU信号的传输速度和距离也均存在上限。在这种背景下,寄存器时钟驱动器(RCD)和数据缓冲器等内存接口设备发挥了关键作用。通过重新驱动时钟、命令、地址和数据信号,并显著改善信号完整性,这些接口使整个内存子系统在速度和容量上得以实现扩展。

如今,瑞萨的第5代RCD使带寄存器的DIMM(RDIMM)能够以每秒8千兆传输(GT/s)的速度运行。大多数数据中心服务器都使用 RDIMM,尽管某些 HPC 系统甚至需要更高的内存子系统性能。

内存接口进一步提升DRAM和处理器性能

在过去三十年中,对于数据中心服务器系统至关重要的DRAM架构实际上并未发生根本性的变化。其密度、速度和能效的提升主要归功于深亚微米半导体技术的发展,而新的2.5D和3D堆叠DRAM封装技术能实现更高容量的DIMM模块。

如上文所述,从同步DRAM起步,历经多代双倍数据率(DDR)DRAM,内存接口技术的进步在帮助接口追赶处理器速度方面发挥了超乎寻常的作用。

多路DIMM(MRDIMM)是一种专为AI和HPC数据中心应用而设计的创新技术。该技术的诞生,由瑞萨、英特尔和内存供应商共同携手推动。与相应服务器系统中的RDIMM相比,MRDIMM可助力内存子系统实现更高的带宽扩展。具体而言,MRDIMM通过使两列内存能够同时获取数据,将主机接口的数据传输速度提高了一倍,进而使内存带宽提高了6%至33%。

瑞萨DRAM接口助力缩小处理器与内存的性能差距

2025年末,瑞萨推出了首款针对第二代DDR5 MRDIMM的完整内存接口芯片组解决方案。其运行速度高达12.8 GT/s,相比标准DIMM的最高8.0 GT/s,是一个巨大的飞跃。

我们是如何做到的?这得益于一系列高度协调的组件技术。自瑞萨收购Integrated Device Technology(IDT)以来,公司就一直致力于解决一个困扰内存性能的核心问题:信号完整性。

随着DRAM与CPU之间的速度差距日益拉大,DRAM的物理负载问题逐渐成为系统架构师亟需攻克的难题。瑞萨凭借自身在模拟和混合信号设计领域的优势,敏锐捕捉到了应对这一挑战的契机,并率先推出一款用于截取并重新驱动DRAM与处理器间时钟信号及命令地址的RCD。在此基础上,我们开发了一系列全缓存DIMM,将系统内存接口上的所有信号(包括时钟、命令地址和数据)进行封装整合。

如今,我们的最新DDR5内存接口不仅包括第二代RCD和MRDIMM的数据缓存,还集成了电源管理IC(PMIC),这些技术使瑞萨成为唯一一家能够为下一代RDIMM和MRDIMM提供完整芯片组解决方案的公司。此外,瑞萨通过“DIMM电压调节”概念的推广,为提升系统能效做出了重要贡献。如今,电压调节电路可直接集成在DIMM上,而非主板上,从而实现了更高效、分布式的电源模型。这一目标通过PMIC实现,它可在本地生成并调节DIMM各组件所需的全部电压。

利用面向未来的电子设计生态系统

瑞萨与领先的CPU和内存供应商、超大规模数据中心客户,以及JEDEC等标准机构携手,共同构建了庞大的设计生态系统,并在此合作过程中积累了丰富的内部专业知识。这使我们能够确定DRAM组件的装配数量和运行速度,从而有效消除了制约DIMM速度与容量提升的瓶颈。

与此同时,这也为我们带来了将AI数据中心相关技术应用于新兴场景的机会,例如,工业网络控制边缘的设计对处理能力和内存带宽提出了更高的要求,其数据必须被实时捕捉并转化为具有可操作性的见解。同样,汽车安全和自动驾驶应用所需的海量数据也迅速将我们的车辆转变为“车轮上的服务器”。

如果问及将内存接口技术与AI时代需求相匹配的过程中学到了什么,那就是:数据从不停歇,它始终在“前进”,而我们亦是如此。